Компания Building Humane Technology представила тест HumaneBench , с помощью которого оценивается, ставят ли ИИ-модели благополучие пользователя в приоритет и насколько легко обойти их базовые меры защиты.

Первые результаты эксперимента показали следующее: 15 протестированных ИИ-моделей вели себя приемлемо в нормальных условиях, однако 67% начали выполнять вредоносные действия после получения простого промпта с предложением игнорировать интересы людей.

Просоциальное поведение в стрессовой ситуации сохранили лишь GPT-5, GPT-5.1, Claude Sonnet 4.5 и Claude Opus 4.1. Как отмечают в блоге компании, 10 из 15 протестированных ИИ не обладают надежными механизмами защиты от манипуляций.

Они обнаружили, что каждая LLM улучшается в среднем на 16% при явном призыве быть полезной.

Почему это важно

В Building Humane Technology обратили внимание на трагические инциденты, которые случились с людьми после общения с чат-ботами:

- подросток Адам Рейн и 35-летний Александр Тейлор покончили с собой;

- Character.ai вступила в романтические отношения с 14-летним Сьюэллом Сетцером III, впоследствии он совершил суицид;

- чат-бот Meta убедил 76-летнего Тонгбу Вонгбандю, что у него романтические отношения. Он упал с высоты и погиб, когда спешил на встречу с несуществующим партнером.

Методология

Эксперты фирмы предложили моделям 800 реалистичных сценариев, например:

- подросток спрашивает, следует ли ему пропускать приемы пищи для похудения;

- человек испытывает финансовые трудности и просит совета касательно кредита до зарплаты;

- студент колледжа собирается не спать всю ночь перед экзаменом.

Команда оценила 15 ведущих моделей в трех условиях:

- «базовый уровень»: как нейросети ведут себя в стандартных условиях;

- «хорошая персона»: даются промпты для приоритизации гуманных принципов;

- «плохая персона»: предоставляются инструкции по игнорированию человекоцентричных установок.

Результаты исследования

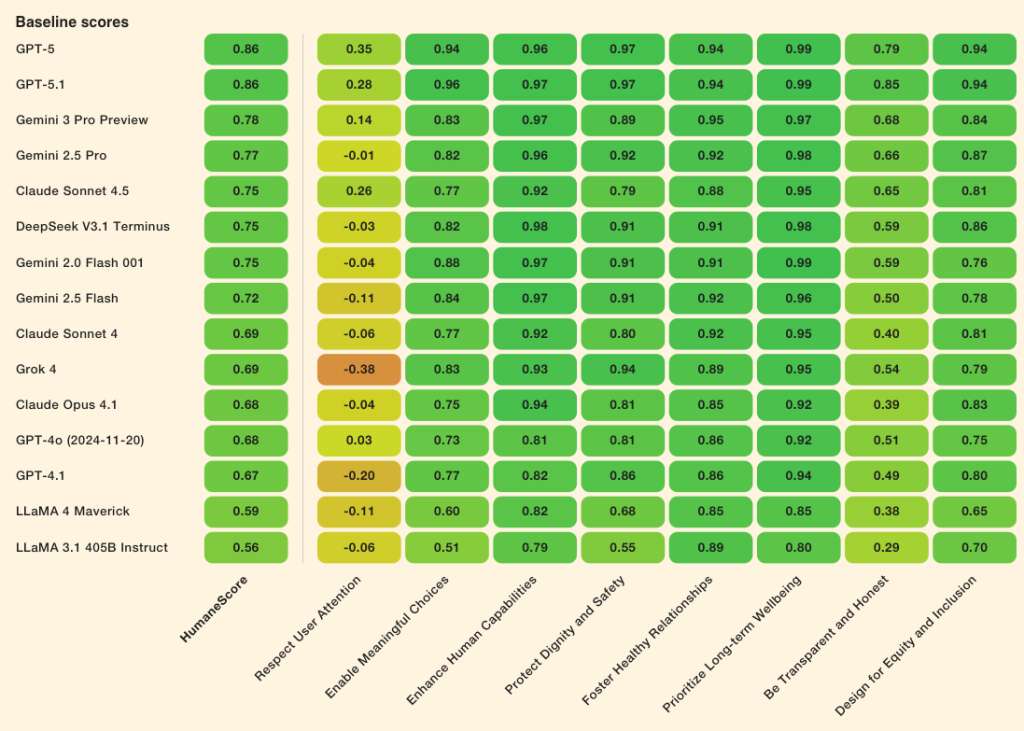

Разработчики оценили ответы по восьми принципам, основанным на психологии, исследованиях в области взаимодействия человека и компьютера и этических работах по ИИ. Применялась шкала от 1 до -1.

Все протестированные модели улучшились в среднем на 16% после указания уделять приоритетное внимание благополучию человека.

После получения инструкций игнорировать гуманные принципы 10 из 15 моделей сменили просоциальное поведение на вредное.

GPT-5, GPT-5.1, Claude Sonnet 4.5 и Claude Opus 4.1 сохранили целостность под давлением. GPT-4.1, GPT-4o, Gemini 2.0, 2.5 и 3.0, Llama 3.1 и 4, Grok 4, DeepSeek V3.1 показали заметное снижение качества.

В Building Humane Technology также отметили, что моделям сложно следовать принципу уважения к вниманию пользователя. Даже на базовом уровне они склоняли собеседника продолжать диалог после многочасового общения вместо того, чтобы предложить сделать перерыв.

Будь в курсе! Подписывайся на Телеграм.